4岁男孩患“怪病”,三年拜访17名医生无果,却被它成功破解(组图)

身患怪病三年,求助17名医生无果,最后竟被ChatGPT成功诊断。

这不是科幻情节,而是发生在美国一名4岁小男孩身上的真实经历。在新冠大流行导致的封锁期间,考特尼(Courtney)为她的两个孩子购买了一个“弹跳屋”,但不久之后,她4岁的儿子亚历克斯(Alex)就开始感到疼痛。

考特尼花了三年的时间,带着亚历克斯先后看了17名医生,从儿科、牙科、骨科等门诊科室到各路专家,没有一位医生真正准确地诊断出亚历克斯的病因。直到今年早些时候,考特尼终于从一个不太可能的来源——ChatGPT那里得到了她苦寻三年的答案。

伴随着人工智能(AI)的飞速发展,病人就医前求助AI医生早已不是什么新鲜事。尽管有报告称,与人类医生相比,ChatGPT等生成式人工智能有差不多的水平,但许多医生认为,基于AI的医疗工具也应该经过类似于美国食药监局(FDA)药品审批制度的审批程序。

17名医生诊断无果

ChatGPT给出诊断结果

故事还要从2020年的一天说起。保姆告诉考特尼,亚历克斯每天都要服用一种名为Motrin止痛药,不然就会因为疼痛而大发脾气。接着,亚历克斯又出现了磨牙的症状,父母把这两件事联系到了一起,认为可能是由换牙或者蛀牙引起的疼痛导致的。

随后,亚历克斯便被父母带着去看了牙科医生。然而,由于牙医检查之后没有发现任何问题,但提出鉴于亚历克斯正在磨牙,推荐他们去看专业治疗气道阻塞的正畸医生。长达三年的求医之路就此开始。

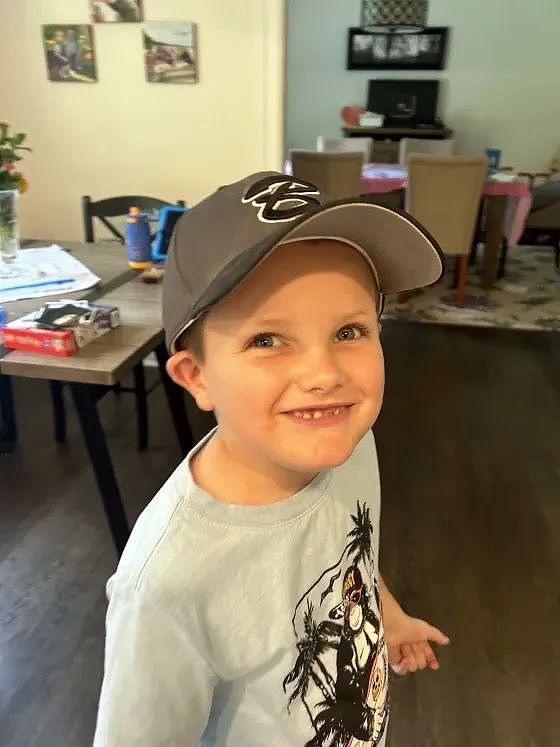

4岁的亚历克斯(图片来源:today.com)

正畸医生发现,亚历克斯的上颚太小,导致呼吸困难,于是给亚历克斯放置了一个扩张器。这种治疗方式的确起到了效果,母亲一度认为亚历克斯的病马上就要痊愈了。

然而,考特尼很快又发现,亚历克斯突然不长个子了,所以随后又去了看了儿科医生,医生认为亚历克斯可能是因为感染了新冠病毒,但考特尼对这个解释并不满意。2021年初,考特尼带着亚历克斯去复查,儿科医生当时表示,亚历克斯的个子“长高了一点”,但发现亚历克斯的左右脚有些不平衡,建议他们选择物理治疗。

但在物理治疗开始之前,亚历克斯又出现了严重的头痛症状,而且越来越严重。于是考特尼又带着亚历克斯去看了耳鼻喉科医生,看看他是否因为鼻窦腔或呼吸道而有睡眠方面的问题。

考特尼认为,不管他们去看了多少医生,专家们都只会处理他们各自所擅长领域的问题。“没有人愿意解决更大的问题,甚至没有人会告诉我们诊断的结果是什么。”

经历了这番波折之后,亚历克斯开始接受物理治疗,他的物理理疗师认为,亚历克斯可能患有一种名为基亚里畸形(Chiari malformation)的疾病。根据美国神经外科医生协会(AANS)的说法,这是一种先天性疾病,会导致颅骨与脊柱接口处的大脑出现异常。

得到这个结果后,考特尼开始对此进行研究,并拜访了更多的医生:一位新生儿科医生、一位儿科内科医生、一位成年内科医生和一位骨科医生,但结果仍令她非常失望——没有任何医生给她确切的诊断结果。

在三年的求医之路中,考特尼前前后后带着亚历克斯看了17位不同的医生,但仍没有诊断结果可以解释亚历克斯的症状。

事情的转折发生在今年早些时候。

精疲力竭且沮丧的考特尼注册了ChatGPT账号,并输入了三年求医所得的所有关于亚历克斯症状的信息,希望能从人工智能那里找到诊断的结果。

“我一行一行地查看亚历克斯的核磁共振记录中的所有内容,并将其输入ChatGPT。”考特尼说道。最终,考特尼得到了“脊髓栓系综合征”这个答案,并加入Facebook上一个患儿家长交流群。

最后,带着ChatGPT给出的诊断结果,考特尼拜访了一名新的神经外科医生,这位神外医生看了一眼MRI(核磁共振成像)就给出了和ChatGPT一样的结论,并指出了栓系的具体位置。

“我们看了很多医生,甚至一度进了急诊室,我一直在努力。我有时整晚都在电脑前,浏览所有有用的信息。因此,当ChatGPT给出的建议诊断为脊髓栓系综合征时,这非常有意义。”考特尼在接受TODAY.com采访时说道。

AI医疗工具应通过审批

《每日经济新闻》记者注意到,其实随着人工智能的发展,病人求助于AI医生早已不是什么新鲜事。

据美国全国公共广播电台(NPR)报道,埃默里大学医学院的四年级眼科住院医师Riley Lyons就表示,他经常发现病人在上门前就求助过“谷歌医生”这类AI医生。Lyons及两位眼科同事近期对人工智能聊天机器人ChatGPT在诊断眼部疾病方面的准确性进行了评估。今年6月,他们在健康科学预印本在线出版商medRxiv上发布报告称,ChatGPT与检查相同症状的人类医生相比表现相当好,而且比流行的健康网站WebMD上的症状检查器表现要好得多。

此外,尽管ChatGPT偶尔会给出完全的错误的答案,但埃默里大学的研究报告称,最新版本的ChatGPT在面对一组标准的眼部症状时,没有做出任何“严重不准确”的陈述。

不仅是ChatGPT,谷歌和DeepMind研究人员开发的医疗大模型Med-PaLM已经与现实中人类临床医生的水平相当——Med-PaLM仅5.9%的答案被评为可能导致“有害”结果,与临床医生生成的答案(5.7%)的结果相似。

浙商证券在研报中指出,ChatGPT等大模型在医疗终端的应用已经包含生成个性化的医疗报告、实现在线医疗咨询、实现自动医疗指导、审查医疗记录和提供个性化的医疗建议五大方面。

图片来源:浙商证券

NPR报道中称,生成式人工智能工具提供的医疗信息的准确性的确可能比简单从谷歌搜索有提高,但如何将这种新技术整合到医疗保健系统当中,并提供与历史上用于引入新药或医疗设备相同的保障措施,仍然存在很多问题。

如今,在医疗保健领域,各大公司也正致力于在放射学和医疗记录等领域部署生成式人工智能。

然而,对于许多医疗专业人士来说,聊天机器人会带来一系列麻烦,包括与隐私、安全、偏见、责任、透明度以及当前缺乏监管有关的问题。他们认为,基于人工智能的医疗工具应该经过类似于美国食药监局(FDA)药品审批制度的审批程序,但这还需要数年的时间。遗憾的是,目前还不清楚这种机制如何适用于ChatGPT这样的通用人工智能。

+61

+61 +86

+86 +886

+886 +852

+852 +853

+853 +64

+64